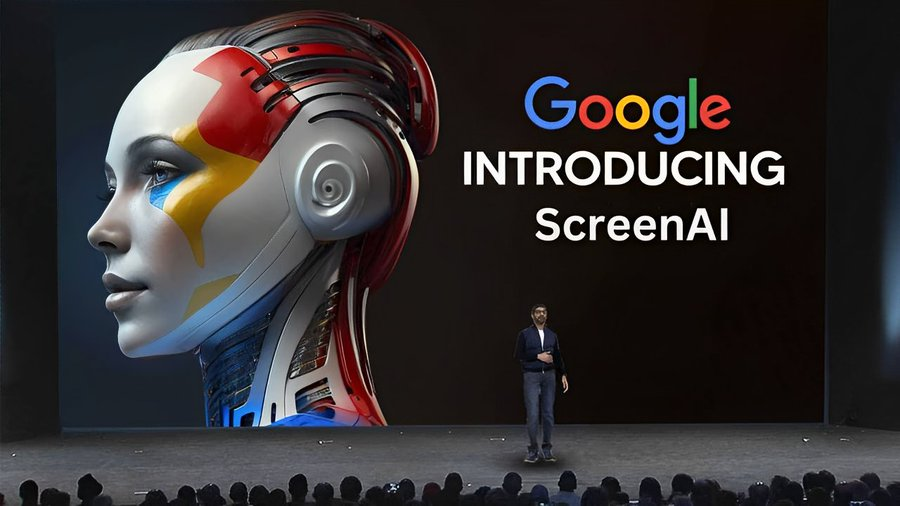

Un Avance Significativo en la Comprensión del Lenguaje Visual

Google Research ha presentado ScreenAI, un modelo de lenguaje visual diseñado para comprender y razonar sobre interfaces de usuario (UI) e infografías. Este modelo representa un avance significativo en la capacidad de las máquinas para interactuar con elementos visuales complejos y facilitar experiencias de usuario ricas e interactivas.

¿Qué es ScreenAI?

ScreenAI es un modelo basado en la arquitectura PaLI, que utiliza una estrategia de parcheo flexible derivada de pix2struct. Con solo 5 mil millones de parámetros, ScreenAI logra resultados líderes en tareas basadas en UI e infografías, superando a modelos de tamaño similar en tareas como Chart QA, DocVQA, y InfographicVQA.

Capacidades y Entrenamiento de ScreenAI

El modelo se entrena en dos etapas: una etapa de preentrenamiento seguida de una etapa de ajuste fino. Durante el preentrenamiento, se aplica aprendizaje auto-supervisado para generar automáticamente etiquetas de datos, que luego se utilizan para entrenar el transformador de visión (ViT) y el modelo de lenguaje. En la etapa de ajuste fino, la mayoría de los datos utilizados están etiquetados manualmente por evaluadores humanos.

Impacto y Futuro de ScreenAI

La introducción de ScreenAI marca un hito en la comprensión del lenguaje visual situado, abriendo nuevas posibilidades para la interacción humano-máquina. Con la liberación de tres nuevos conjuntos de datos: Screen Annotation, ScreenQA Short y Complex ScreenQA, Google Research proporciona herramientas esenciales para evaluar y mejorar continuamente las capacidades de ScreenAI.